1984年,美国国防高级研究计划局(DARPA)启动“ALV自主陆上车辆”,摄像头检测地形,计算机系统计算出导航和行驶路线。采用激光雷达来识别道路,GPS导航,并有小型化的短波雷达发现障碍物。

这些都是,历史上无人驾驶的眼睛。

今天,宝马I3车载硬件包括4个激光感应器,具备多开立柱障碍、紧急刹车的功能。但是这些“眼睛”对于无人驾驶来说是远远不够的。

车载硬件

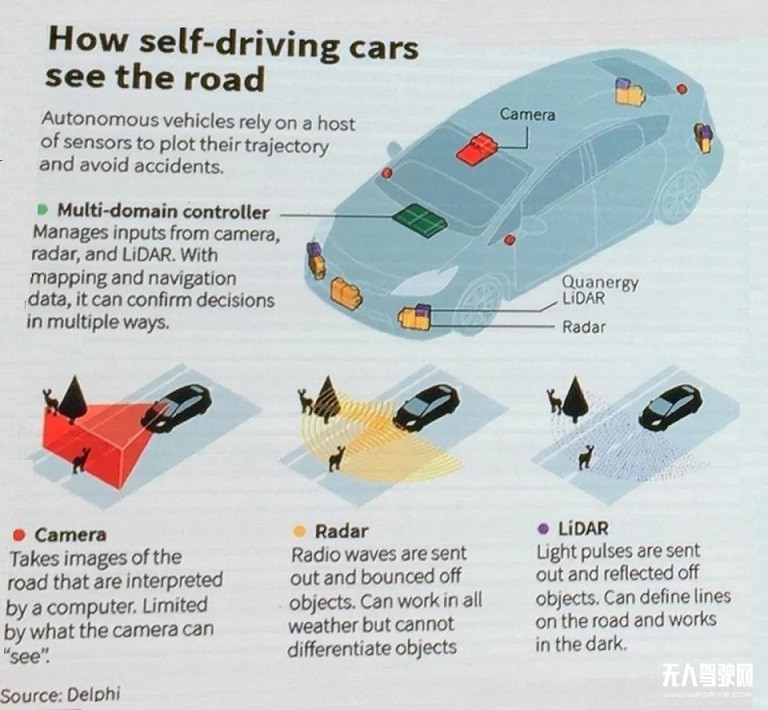

开车需要眼观六路,这样能得到深度、丰富的信息,为驾驶决策提供依据。我们需要清楚的知道车辆周围发生了什么,有什么将会发生。无人驾驶就是用双目系统做感知,计算系统做处理。不同的厂商技术路线不一样,车载无人驾驶硬件,也就是车身上的硬件包括:传感器、激光雷达、摄像头、超声波等等。声波一般是用在慢速的道路场景中。主流的自动驾驶,一般是毫米波雷达,激光雷达和摄像头。但是,摄像头的两个主要限制是:对光的要求很高,运算要求也较大。这时,需要多传感器组合,但是不同场景有不同的传感器配置,简单的场景可能是纯摄像头,有的场景需要是摄像头加超声波,再加上一系列的激光雷达,分有8线激光雷达、16线激光雷达,摄像头也会有很多种不同的配置。也有的无人驾驶的方案是用视觉的方式来做3D感知。比如识别车道线、稳定精确的车辆3D框,同时每辆车都有车辆身份,每个车辆身份都带有这辆车的类型信息,是小轿车、还是货车等等。通过识别可行驶区域,将2D识别的结果投影到3D上,在3D空间中,知道每辆车的位置、每辆车的速度,以及通过历史的数据和当前车的状态去判断它下一个时刻可能发生的运动轨迹和位置。目前国内也有许多初创团队在做视觉加深度学习的感知方案。

高精度地图

对高阶别的(L4)无人驾驶来说地图是一个非常重要的战略资源。布局高级别无人驾驶,必须布局地图,谷歌和百度的无人驾驶,就都有有地图这一先天优势。原因是自动驾驶车载定位的主要输入是定位特征,例如车道标志或者交通标志。这些特征点被储存在定位地图里,并由车载传感器探测。通过比较和分析这些特征,我们知道车辆的位置,以及车头方向,行驶车道内的信息。这也就是为什么传感器需要做识别,联网上报车辆的位置与坐标,这样减少了不少复杂的检测。也有无人驾驶的技术路线是希望基于高精度地图能够做到一个厘米级的定位,然后基于高精度地图做到针对自动驾驶的导航。